- 구축형 AI Agent Builder 비교: 기업을 위한 Agentic AI 플랫폼 구축 가이드

- 1장. LLM 도입 이후, 왜 AI Agent Builder가 필요한가

- 2장. 엔터프라이즈 구축 환경 정의: 폐쇄망·보안·플랫폼 전제

- 3장. AI Agent Builder 아키텍처: 실행 모델·흐름 제어·컨텍스트

- 4장. 업무 적용을 위한 연동 설계: 크롤링·검색·지식베이스 파이프라인

- 5장. 후보 솔루션 기술 분석: n8n, LangFlow, Flowise, Dify

- 6장. 요구사항 매핑 기반 실증 검증: 연결 가능 vs 운영 가능

- 7장. Kubernetes 통합 관점 최종 선정 기준 및 참조 아키텍처

- [핵심 요약] 전문가의 관점에서 다시 보는 주요 개념

- References & Related Links

챗봇을 넘어, 일하는 AI 에이전트 시스템: 구축형 플랫폼 비교 가이드

Kubernetes 기반의 온프레미스 환경에서 ‘실제로 작동하는’ AI 에이전트 시스템을 구축하기 위한 아키텍처와 솔루션 비교 분석을 담고 있습니다.

2026년 01월 22일

구축형 AI Agent Builder 비교: 기업을 위한 Agentic AI 플랫폼 구축 가이드

생성형 AI의 도입은 이제 기업의 선택이 아닌 생존을 위한 필수 과제가 되었습니다. 2024년을 기점으로 많은 기업이 단순한 흥미 위주의 PoC(개념 검증)를 넘어, 실제 비즈니스 프로세스에 AI를 통합하려는 시도를 본격화하고 있습니다. 하지만 막상 현장에서는 “보안이 중요한 우리 회사 폐쇄망(Air-gapped) 환경에 어떻게 최신 AI 기술을 도입할 것인가?”, “수많은 오픈소스 도구 중 우리 인프라에 가장 적합한 것은 무엇인가?”라는 현실적인 난관에 부딪히곤 합니다.

오늘 소개해 드릴 백서 <구축형 AI Agent Builder 비교: 기업을 위한 Agentic AI 플랫폼 구축 가이드>는 바로 이러한 고민을 안고 계신 IT 의사결정자와 엔지니어분들을 위해 작성되었습니다. 이 백서는 클라우드 환경이 아닌, 엄격한 보안과 Kubernetes 기반의 온프레미스(On-premise) 환경에서 ‘실제로 작동하는’ AI 에이전트 시스템을 구축하기 위한 아키텍처와 솔루션 비교 분석을 담고 있습니다.

이 블로그 포스트를 통해 백서의 핵심 흐름을 먼저 살펴보시고, 본문을 다운로드하여 구체적인 구축 전략을 확인해 보시기를 권해 드립니다.

1장. LLM 도입 이후, 왜 AI Agent Builder가 필요한가

많은 기업이 AI 도입을 서두르면서 겪는 첫 번째 문제는 ‘도구의 파편화’입니다.

어떤 부서는 챗봇을 만들고, 어떤 부서는 문서 검색 시스템을 만들지만, 이들이 서로 연결되지 않아 데이터가 고립되는 ‘사일로(Silo)’ 현상이 발생합니다. 1장에서는 이러한 파편화를 해결하고 기업의 AI 자산을 하나로 묶어줄 오케스트레이션 계층, 즉 Agent Builder의 필요성을 역설합니다.

단순히 질문에 대답만 하는 ‘챗봇’과 달리, AI 에이전트(Agent)는 스스로 계획을 세우고 도구를 사용하여 업무를 수행합니다. 예를 들어 “회의실 잡아줘”라고 말했을 때, 챗봇은 “기능이 없습니다”라고 답하지만, 에이전트는 사내 캘린더 API를 조회하고 빈 시간을 찾아 예약을 완료합니다. 이 장에서는 LLM이라는 두뇌에 기업의 API와 데이터라는 손발을 달아주는 Agent Builder가 왜 엔터프라이즈 AI 전략의 핵심이 되어야 하는지, 그리고 이를 통해 어떻게 업무 지능화를 가속화할 수 있는지 설명합니다.

2장. 엔터프라이즈 구축 환경 정의: 폐쇄망·보안·플랫폼 전제

기업의 IT 환경은 자유로운 인터넷 접속이 가능한 개인 개발 환경과 본질적으로 다릅니다. 2장에서는 외부 인터넷이 차단된 폐쇄망(Air-gapped) 환경에서 AI 시스템을 구축할 때 고려해야 할 제약 사항들을 정의합니다. 인터넷 없이 패키지와 의존성을 관리하는 방법, 외부 SaaS API 대신 사내에 구축된 로컬 모델(Local LLM)을 활용하는 전략, 그리고 데이터 유출 방지를 위한 보안 감사 체계가 필수적으로 다루어집니다.

또한, AI 에이전트는 트래픽 변동이 크기 때문에 유연한 자원 관리가 필수적입니다. 따라서 이 백서는 컨테이너 오케스트레이션 표준인 Kubernetes를 기본 운영 환경으로 전제합니다. Kubernetes 위에서 각 Agent Builder를 어떻게 배포하고, 사내 인증 시스템(SSO/LDAP)과 연동하여 권한을 관리할 것인지에 대한 인프라 차원의 요구사항을 상세히 기술하고 있습니다.

3장. AI Agent Builder 아키텍처: 실행 모델·흐름 제어·컨텍스트

Agent Builder는 단순히 LLM API를 호출하는 래퍼(Wrapper)가 아닙니다. 3장에서는 에이전트가 복잡한 업무를 수행하기 위해 갖춰야 할 내부 아키텍처를 심도 있게 분석합니다. 외부 신호에 반응하여 워크플로우를 시작하는 트리거(Trigger) 메커니즘, 대량의 작업을 비동기로 처리하는 워커(Worker) 패턴, 그리고 LLM이 스스로 필요한 도구를 선택하여 실행하는 Function Calling 기술의 작동 원리를 설명합니다.

특히 중요한 것은 ‘기억’입니다. 에이전트가 사용자와의 대화 맥락을 유지하고(단기 메모리), 방대한 사내 지식(장기 메모리)을 적재적소에 꺼내 쓸 수 있도록 하는 컨텍스트 관리 전략을 다룹니다. 또한 기업 환경에서 필수적인 감사(Audit)를 위해, 에이전트가 왜 그런 판단을 내렸는지 근거를 남기는 로그 설계 방안까지 제시합니다.

4장. 업무 적용을 위한 연동 설계: 크롤링·검색·지식베이스 파이프라인

“데이터 없는 에이전트는 껍데기에 불과하다”는 말처럼, 사내 데이터를 에이전트에 주입하는 과정은 매우 중요합니다. 4장에서는 Agent Builder가 직접 데이터를 처리하는 대신, 전문화된 컴포넌트들을 지휘하는 파이프라인 설계를 다룹니다. 웹이나 문서를 수집하는 Crawler, 정확한 검색을 위해 키워드 검색(BM25)과 벡터 검색을 결합하는 하이브리드 검색, 그리고 데이터 간의 관계를 추적하는 GraphDB 활용 전략이 소개됩니다.

단순히 텍스트를 벡터 DB에 넣는 것을 넘어, 문서의 최신성이나 접근 권한 같은 메타데이터를 어떻게 관리할 것인지, 그리고 검색된 결과를 LLM이 이해하기 좋게 재순위화(Reranking)하는 과정이 어떻게 구성되어야 하는지 실무적인 관점에서 설명합니다. 이는 할루시네이션(환각)을 줄이고 답변의 정확도를 높이는 핵심 기술입니다.

5장. 후보 솔루션 기술 분석: n8n, LangFlow, Flowise, Dify

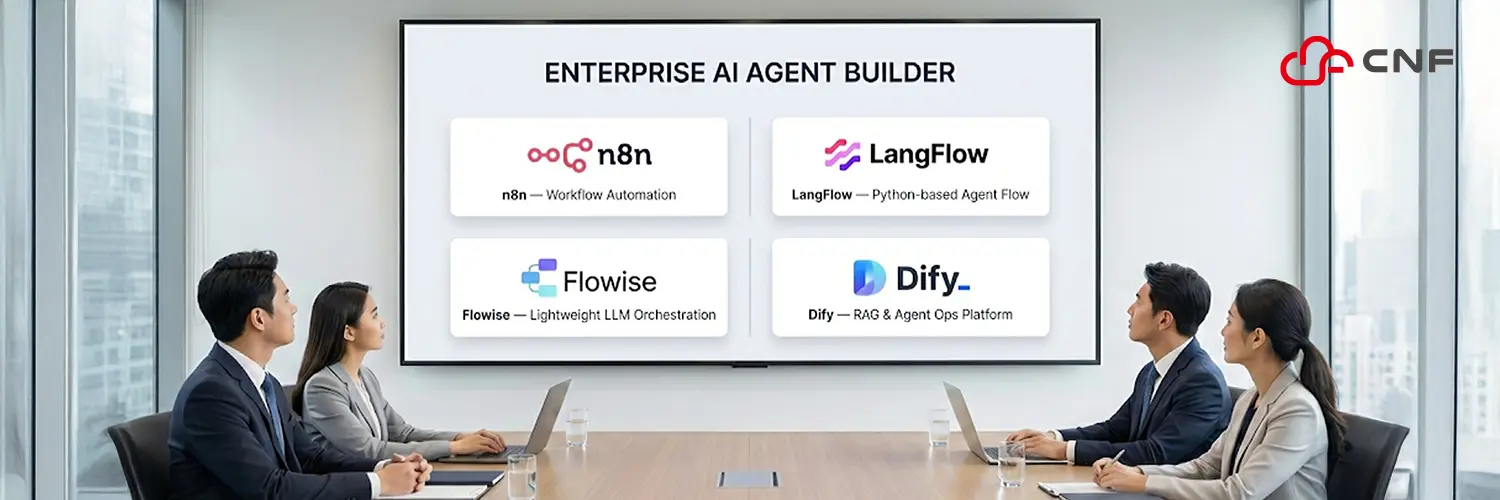

백서의 하이라이트라 할 수 있는 이 장에서는 현재 시장에서 가장 주목받는 4가지 오픈소스 솔루션(n8n, LangFlow, Flowise, Dify)을 엔터프라이즈 관점에서 철저히 비교 분석합니다.

n8n은 워크플로우 자동화에 강력하지만 상용 라이선스 이슈가 있어 도입 시 주의가 필요합니다. LangFlow는 파이썬 기반으로 확장성이 좋지만 UI가 복잡하고 폐쇄망 내 의존성 관리가 까다롭습니다. Flowise는 Node.js 기반으로 가볍고 웹 생태계 친화적이며 라이선스가 자유롭다는 장점이 있습니다. Dify는 RAG 파이프라인과 운영(Ops) 기능까지 통합된 올인원 플랫폼으로 완성도가 가장 높지만, 리소스 요구량이 많고 아키텍처가 무겁습니다. 이 장은 각 도구의 장단점을 명확히 하여, 귀사의 상황에 맞는 최적의 도구를 선택할 수 있는 기준을 제공합니다.

6장. 요구사항 매핑 기반 실증 검증: 연결 가능 vs 운영 가능

기능 명세서에 ‘연동 가능’이라고 적혀 있다고 해서 실무에서 바로 쓸 수 있는 것은 아닙니다. 6장에서는 각 솔루션이 실제 운영 환경에서 겪게 될 문제들을 검증합니다. 대량의 데이터를 처리할 때 에러 핸들링은 잘 되는지, 장애 발생 시 원인을 추적할 수 있는 관측성(Observability)은 확보되어 있는지를 따져봅니다.

특히 주목할 점은 최신 트렌드인 MCP(Model Context Protocol) 지원 여부입니다. MCP는 에이전트와 도구 사이의 연결을 표준화하는 기술로, 이를 통해 사내 레거시 시스템 연동 공수를 획기적으로 줄일 수 있습니다. 각 솔루션이 MCP를 어떻게 지원하는지, 그리고 이를 통해 어떻게 시스템의 확장성을 확보할 수 있는지에 대한 실증적인 분석 결과를 담고 있습니다.

7장. Kubernetes 통합 관점 최종 선정 기준 및 참조 아키텍처

마지막 장에서는 앞선 분석을 종합하여 최종적인 선정 가이드와 참조 아키텍처를 제안합니다. 결론적으로, 사용자 경험과 운영 편의성이 뛰어난 Dify(또는 Flowise)를 메인 오케스트레이터로 사용하되, 무거운 데이터 처리(크롤링, OCR) 등은 별도의 마이크로서비스로 분리하여 Kubernetes 상에서 유기적으로 연동하는 하이브리드 전략을 권장합니다.

또한, 고객사별로 커스터마이징을 최소화하면서도 표준화된 배포를 가능하게 하는 템플릿 전략과, 사내 도구 카탈로그를 구성하여 재사용성을 높이는 방안을 제시합니다. 이는 일회성 구축이 아니라 지속 가능한 플랫폼으로서의 AI 시스템을 설계하는 데 중요한 지침이 될 것입니다.

[핵심 요약] 전문가의 관점에서 다시 보는 주요 개념

백서를 다운로드하기 전, 이 문서가 다루는 핵심 개념들을 IT 전문가의 시각에서 다시 한번 정리해 드립니다.

1. 수동적 챗봇을 넘어선 ‘행동하는 에이전트(Acting Agent)’

지금까지의 AI가 사용자의 질문에 단순히 텍스트로 답하는 수준이었다면, AI 에이전트는 실제 업무를 수행하는 주체입니다. “보고서 써줘”라는 요청을 받으면, 필요한 데이터를 DB에서 조회하고(도구 사용), 내용을 요약하여(추론), 이메일로 발송하는(행동) 전 과정을 스스로 계획하고 실행합니다. 이 백서는 이러한 에이전트를 만드는 ‘공장’을 어떻게 구축할 것인가에 대한 이야기입니다.

2. 정확도를 높이는 ‘하이브리드 검색’과 ‘GraphRAG’

기업 데이터 검색에서 벡터 검색(Semantic Search)만으로는 한계가 있습니다. “A-123 프로젝트” 같은 정확한 모델명이나 코드를 찾으려면 키워드 검색(BM25)이 병행되어야 합니다. 더 나아가, 백서에서는 데이터 간의 연결 관계를 파악하는 GraphDB를 활용하여 답변의 맥락과 깊이를 더하는 고도화된 RAG 전략을 설명합니다.

3. 폐쇄망 환경에서의 ‘운영 가능한(Operable)’ 시스템

인터넷이 차단된 환경에서 오픈소스 AI 도구를 운영하는 것은 ‘설치’ 이상의 문제입니다. 외부 라이브러리 의존성 해결, 로컬 LLM 연동, 그리고 보안 감사 로그 체계 구축 등 엔터프라이즈 환경 특유의 제약 사항을 어떻게 극복할 것인지에 대한 실질적인 해법을 제시합니다.

4. 연결의 표준화, ‘MCP (Model Context Protocol)’

과거에는 AI 도구마다 연동 코드를 따로 짜야 했지만, 이제는 MCP라는 표준 프로토콜을 통해 한 번 만든 연결 도구를 어디서든 재사용할 수 있습니다. 이는 시스템의 유연성을 높이고 벤더 종속성을 탈피하는 핵심 기술로, 백서에서 비중 있게 다뤄집니다.

지금 바로 백서를 다운로드하세요.

AI 기술은 빠르게 변하고 있지만, 기업 시스템을 지탱하는 아키텍처의 원칙은 견고해야 합니다. 이 백서는 유행하는 도구를 나열하는 데 그치지 않고, 기업의 자산이 될 수 있는 지속 가능한 AI 플랫폼 구축의 청사진을 제공합니다. 귀사의 AI 도입 전략을 한 단계 도약시킬 구체적인 가이드를 지금 바로 확인해 보시기 바랍니다.

References & Related Links

- MIT Study on AI Failures: MIT Study: 95% of AI Projects Fail. Here’s How to Be The 5%

- Loris AI Blog: Conversation Intelligence for Leading Brands

- Event-Driven Multi-Agent Design: AI Agents Must Act, Not Wait

- n8n License Policy: Sustainable Use License | n8n Docs

- Flowise GitHub & License: Flowise GitHub, Apache 2.0 License

- LangFlow GitHub & License: LangFlow GitHub, MIT License

- Dify GitHub & License: Dify GitHub, Apache 2.0 License